Open-Source-LLMs sind einer der wichtigsten KI-Trends für 2025.

Und das nicht zu Unrecht:

Open-Source-Modelle waren lange Zeit deutlich schwächer als proprietäre Modelle. Aber dieses Jahr haben sie aufgeholt:

Mit GPT-OSS-120B, DeepSeek R1, Qwen3-235B-A22B-Thinking, Llama 4 Maverick und Kimi K2 sind Modelle erschienen, die sich mit den besten proprietären LLMs wie GPT-5, Claude 4.5 oder Gemini 2.5 messen können (und diese in manchen Benchmarks sogar übertreffen).

In diesem Artikel findest du einen Überblick über die aktuell 50 besten Open-Source-LLMs mit ihren wichtigsten Benchmark-Scores und Lizenzen.

Zudem zeige ich dir, wie du freie LLMs einfach und kostenlos auf deinem Rechner nutzen kannst (ohne programmieren oder das Terminal nutzen zu müssen).

- GPT-OSS-120B (OpenAI), DeepSeek R1 und Qwen3-235B führen 2025 die Open-Source-Rankings an und übertreffen GPT-4 in vielen Benchmarks (MMLU: 90 %+, MATH: 97 %+)

- 50 Open-Source-LLMs mit verschiedenen Lizenzen verfügbar - von MIT über Apache 2.0 bis zu eingeschränkten kommerziellen Lizenzen

- Neue 2025er-Modelle wie Llama 4 Maverick, Kimi K2 und Gemma 3 27B setzen neue Maßstäbe für Effizienz bei kleineren Modellgrößen

- Lokale Nutzung mit Tools wie Ollama, LM Studio oder GPT4All möglich - benötigt aber leistungsstarke Hardware (RTX 4090+ empfohlen)

Open-Source-LLMs im Vergleich

Farbcodierung der Benchmark-Scores:

1. Die wichtigsten Benchmarks erklärt

Um die Open-Source-LLMs objektiv zu vergleichen, nutze ich drei zentrale Benchmark-Kategorien:

MMLU / MMLU-Pro: Der Massive Multitask Language Understanding Benchmark testet allgemeines Wissen über 57 Fächer hinweg (STEM, Sozialwissenschaften, Geisteswissenschaften). MMLU-Pro ist die anspruchsvollere Variante mit weniger Kontamination. Top-Modelle erreichen hier 85–90 %.

MATH / GPQA: Diese Benchmarks testen mathematisches und wissenschaftliches Reasoning. MATH-500 enthält anspruchsvolle Mathematikaufgaben, während GPQA (Graduate-Level Physics Questions Answers) Expertenwissen in Biologie, Physik und Chemie testet. Top-Modelle erreichen hier 70–97 %.

HumanEval / LiveCodeBench: Diese Benchmarks testen Code-Generierung. HumanEval enthält Python-Programmieraufgaben, LiveCodeBench testet Code-Performance mit aktuellen, nicht kontaminierten Aufgaben. Top-Modelle erreichen hier 60–90 %.

Die Tabelle zeigt für jedes Modell drei Benchmark-Scores, die je nach Stärke des Modells variieren (z. B. Code-fokussierte Modelle haben höhere HumanEval-Scores).

2. Die Top-Modelle 2025

GPT-OSS-120B von OpenAI führt die Rankings an (MMLU: 90,0 %, GPQA: 80,1 %, AIME: 96,6 %) und ist das erste Open-Weight-Modell von OpenAI seit GPT-2.

DeepSeek R1 mit seinen 671 Milliarden Parametern (nur 37B aktiv) übertrifft GPT-4 in vielen Bereichen (MMLU: 90,8 %, MATH-500: 97,3 %) und wurde mit nur $5,6 Millionen trainiert.

Qwen3-235B-A22B-Thinking von Alibaba setzt neue Maßstäbe für Reasoning (AIME25: 92,3 %, LiveCodeBench: 74,1 %) und übertrifft DeepSeek R1 in 17 von 23 Benchmarks.

Llama 4 Maverick von Meta erreicht mit nur 17B aktiven Parametern (von 400B total) beeindruckende Scores (MMLU-Pro: 80,5 %, GPQA: 69,8 %) und schlägt deutlich größere Modelle.

3. LLM-Lizenzen erklärt

Hier findest du einen Überblick über die am häufigsten verwendeten Lizenzen bei Open-Source-LLMs.

MIT License

Eine sehr freizügige Open-Source-Lizenz, ähnlich wie Apache 2.0. Sie erlaubt die uneingeschränkte Nutzung, Modifikation und Weitergabe des LLMs, auch in proprietären Programmen, solange der Urheberrechtshinweis erhalten bleibt. DeepSeek V3 verwendet MIT mit einigen Einschränkungen für militärische Nutzung.

Llama 2 Community / Llama 3 Community

Unter den Lizenzen hat Meta Llama 2 und Llama 3 veröffentlicht. Sie erlauben die kostenlose Nutzung der LLMs für Forschung und kommerzielle Anwendungen mit bis zu 700 Millionen monatlich aktiven Nutzern. Der Quellcode und die Modellgewichte sind frei verfügbar.

Qwen License / Qianwen LICENSE

Die Qwen-Modelle werden unter verschiedenen Lizenzen veröffentlicht. Während kleinere Modelle oft unter Apache 2.0 lizenziert sind, haben größere Modelle wie Qwen2.5-72B spezielle Lizenzbedingungen, die kommerzielle Nutzung mit bestimmten Einschränkungen erlauben.

Apache 2.0

Eine sehr freizügige Open-Source-Lizenz, die nur minimale Beschränkungen vorsieht. Sie erlaubt die Nutzung, Modifikation und Weitergabe des LLMs, auch in proprietären Programmen, solange der Urheberrechtshinweis erhalten bleibt. Sie enthält keine Copyleft-Klausel.

CC BY-NC-4.0

Eine Creative-Commons-Lizenz, die es erlaubt, das LLM in jeglicher Form zu bearbeiten und zu teilen, jedoch nicht für kommerzielle Zwecke. Der Name des Urhebers muss genannt werden.

CC BY-NC-SA-4.0

Ähnlich wie CC BY-NC-4.0, jedoch mit der zusätzlichen Share-Alike-Bedingung. Das bedeutet, Forks oder bearbeitete Versionen eines LLMs müssen unter den gleichen Bedingungen weitergegeben werden.

nicht-kommerziell

Hier ist die Nutzung des LLMS für kommerzielle Zwecke untersagt. Was genau als „kommerziell" gilt, ist aber nicht immer eindeutig definiert oder eingegrenzt.

Meistens sind „nicht-kommerzielle" Modelle nur für Forschungszwecke oder zur privaten Nutzung freigegeben.

4. Open-Source-LLMs lokal auf dem eigenen Rechner nutzen

Open-Source-LLMs lokal auf dem eigenen Rechner zu nutzen, geht einfacher, als du vielleicht denkt:

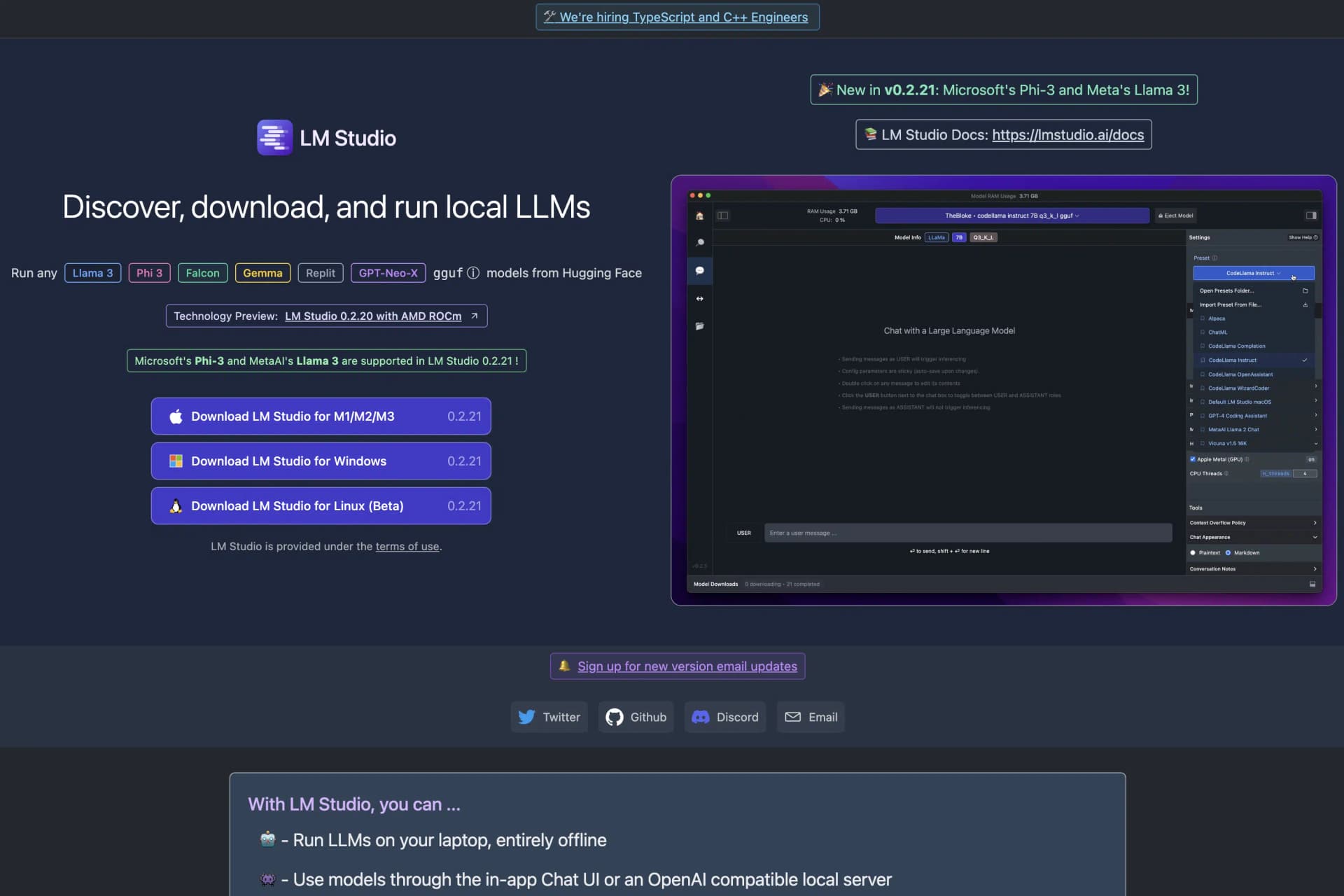

1. Lade LM Studio herunter

Lade LM Studio von der Website herunter. Es ist kostenlos und für Mac, Windows und Linux verfügbar:

2. Installiere und öffne LM Studio

Im nächsten Schritt installierst du LM Studio auf deinem Rechner und öffnest es.

3. Lade gewünschte Open-Source-LLMs herunter

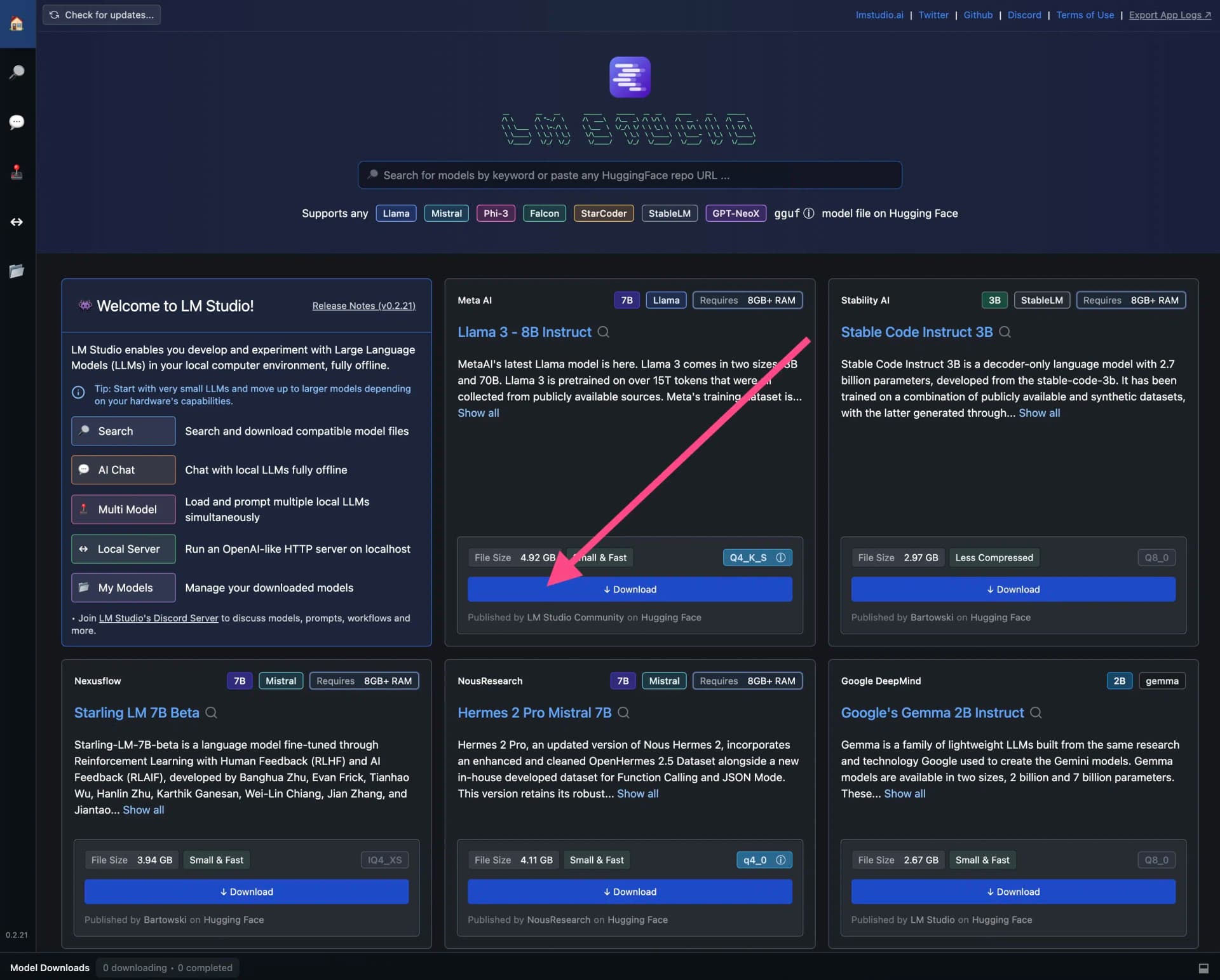

Jetzt musst du die Open-Source-LLMs in LM Studio herunterladen, die du nutzen möchtest.

Viele beliebte LLMs findest du bereits auf dem Startbildschirm. Um ein LLM herunterzuladen, klickst du einfach auf den blauen Download-Button:

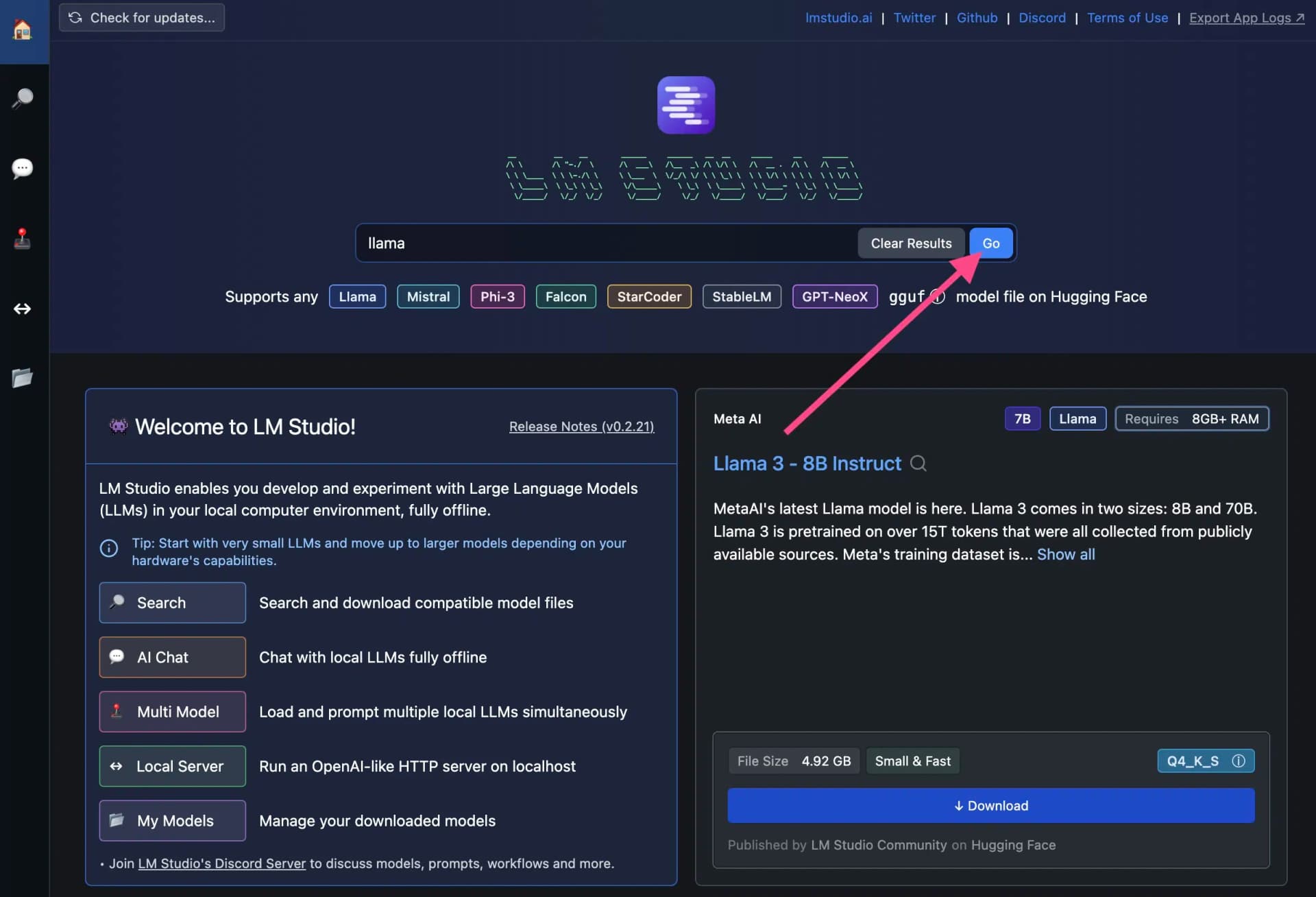

Um bestimmte Open-Source-LLMs zu finden, kannst du auch die Suchfunktion nutzen:

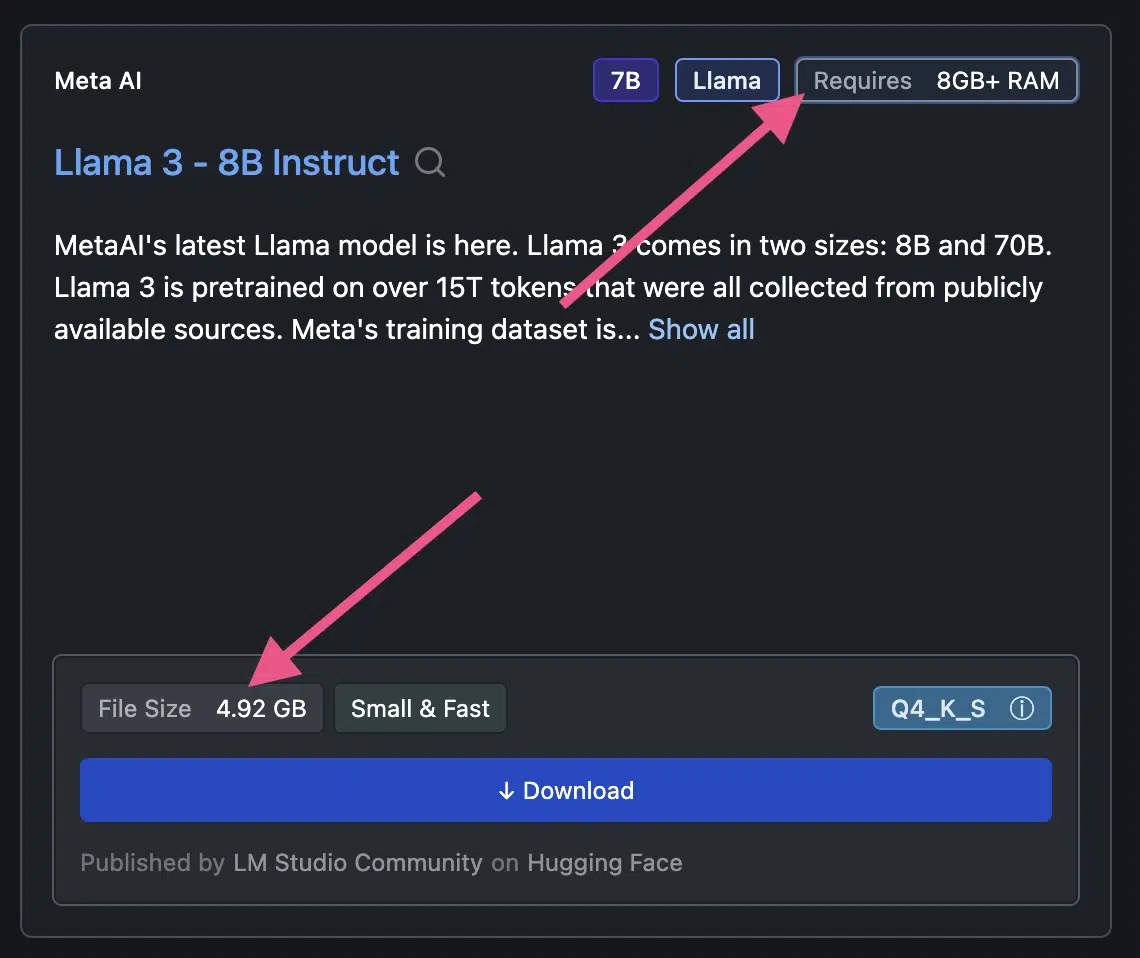

4. Wichtig: Vor dem Download Systemvoraussetzungen beachten

Bevor du ein LLMs herunterlädst, solltest du dir die Systemvoraussetzungen anschauen.

Lllama 3 benötigt zum Beispiel mehr als 8 GB RAM und 4,92 GB freien Speicherplatz:

5. Mit dem Open-Source-LLM chatten

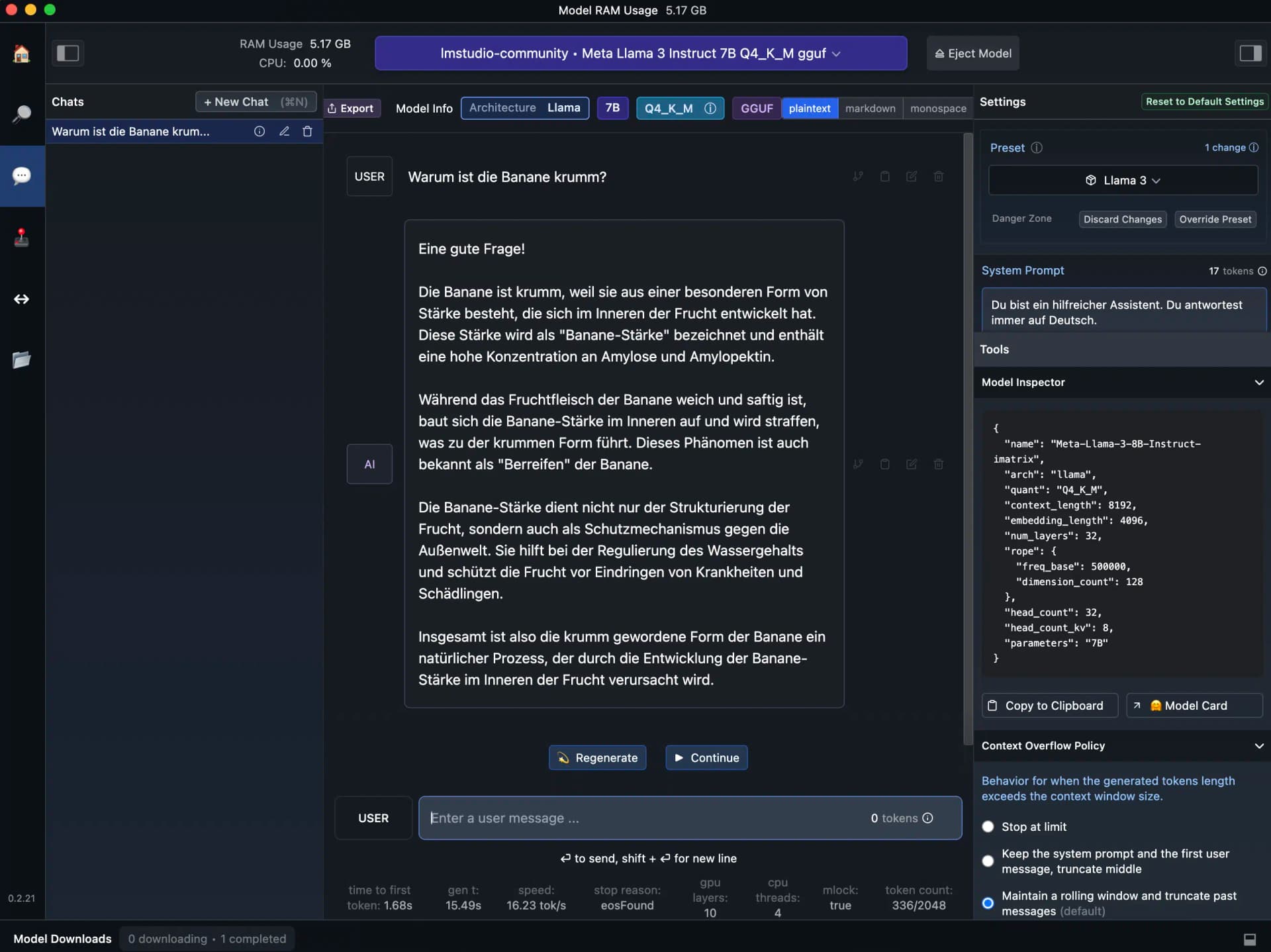

Nachdem du ein Open-Source-LLM heruntergeladen hast, kannst du es direkt in LM Studio nutzen.

Dazu klickst du einfach links in der Seitenleiste auf das Sprechblasen-Icon (?).

Die Benutzeroberfläche und die Einstellungsmöglichkeiten erinnern dabei an den OpenAI Playground: